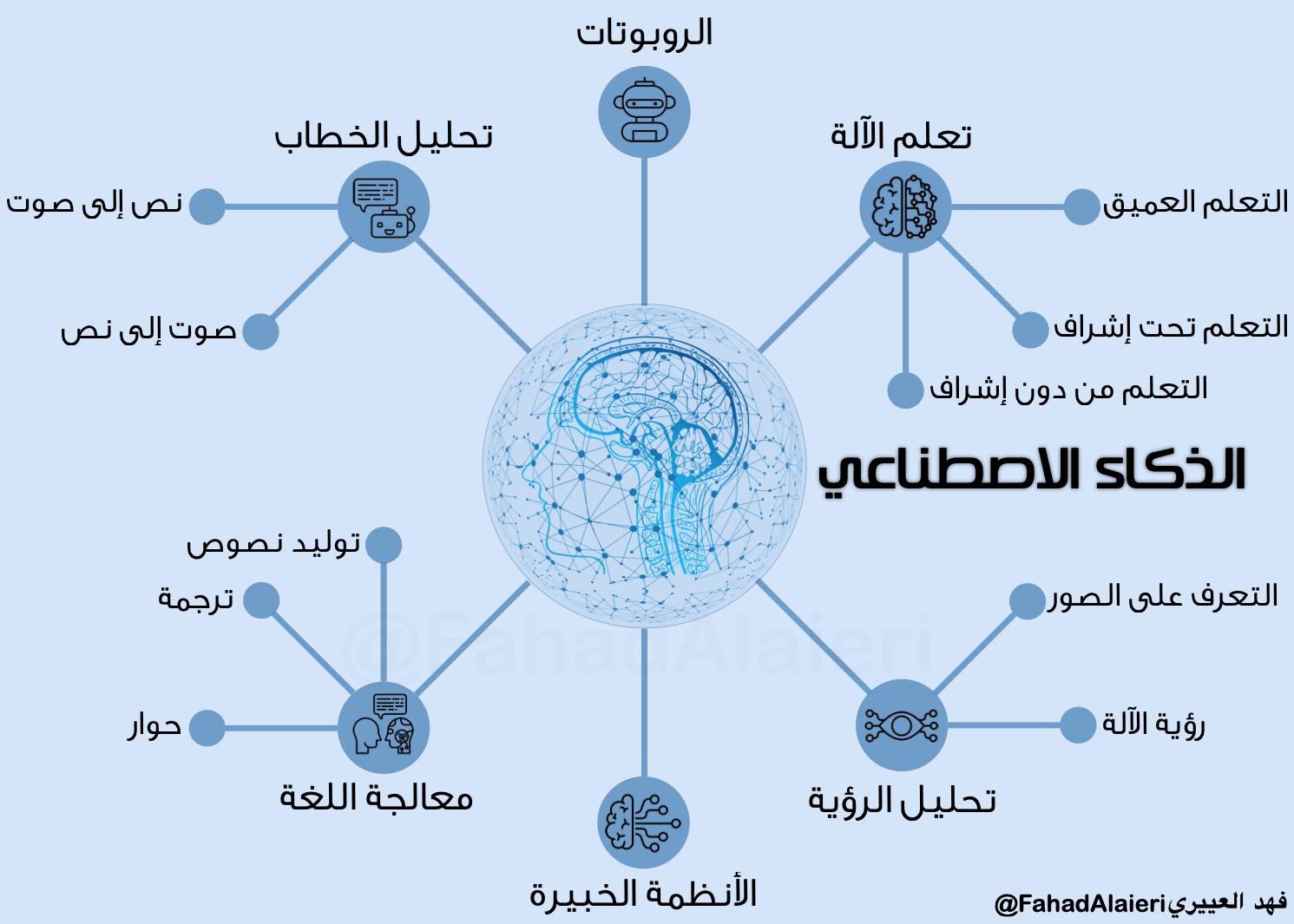

يتوقع الخبراء وخلال عدة سنوات أن الروبوتات ستكون موجودة بكل منزل وبكل مكتب وربما روبوت لكل شخص كما هو الحال الآن مع الهواتف الذكية. حاليا تُستخدم الروبوتات لغرض عمليات الإنتاج بالمصانع، للمستودعات، لمساعدة الناس في المطارات والأسواق والفنادق، لاكتشاف المحيطات والفضاء، وغيرها من الاستخدامات. الأنظمة الذكية كذلك تُصمم لاستخدامات متفرقة سهلت حياة الناس، مثل الصحة، التعليم، الحكومة الإلكترونية، والتجارة والصناعة.

تأثير تلك التقنيات الذكية على المجتمع كبير حيث يعتمد الناس عليها ويستخدمونها للتواصل ولأداء مهامهم واتخاذ القرارات. لذلك لابد من ضبط ذلك الاستخدام لتعزيز ايجابياته. ولضبط استخدامات الذكاء الاصطناعي يلزم على عدة جهات ان تشترك ويكون لها دور في هذه العملية. إحدى تلك الجهات هي الحكومات والتي بدورها تحكم صناعة التقنيات الذكية وتحمي الناس من سلبياتها.

نظرا لتطور تقنيات الذكاء الاصطناعي، وجب على الشركات المصنّعة أن تضمن سلامتها. فأنظمة وآلات الذكاء الاصطناعي أصبحت قادرة الآن على جمع البيانات وتحليلها واتخاذ القرارات بشكل ذاتي نيابة عن الانسان. فعملية جمع البيانات والتحليل واتخاذ القرار بشكل ذاتي لابد ان تكون محكومة بسياسات ومبادئ مقبولة لدى المجتمعات.

حوكمة الذكاء الاصطناعي تشمل بشكل عام وضع سياسات وقوانين واخلاقيات تشمل الشفافية والتفسير، العدالة والنزاهة، الأمن والسلامة، والمسؤولية. وهذا لإنتاج واستخدام وتطوير الذكاء الاصطناعي بحيث نتأكد أن البشرية تستفيد منه ولا يؤثر عليها بشكل سلبي، وتحفظ المصلحة العامة وحقوق أصحاب المصالح (وهم الحكومة، صنّاع السياسات، المشرعون، المنظمون، الشركات المصنّعة، المستخدمين، والمجتمع)، إضافة إلى تحديد المخاوف ومعالجتها، ودراسة الاثار الأخلاقية والقانونية لاستخدامات الذكاء الاصطناعي.

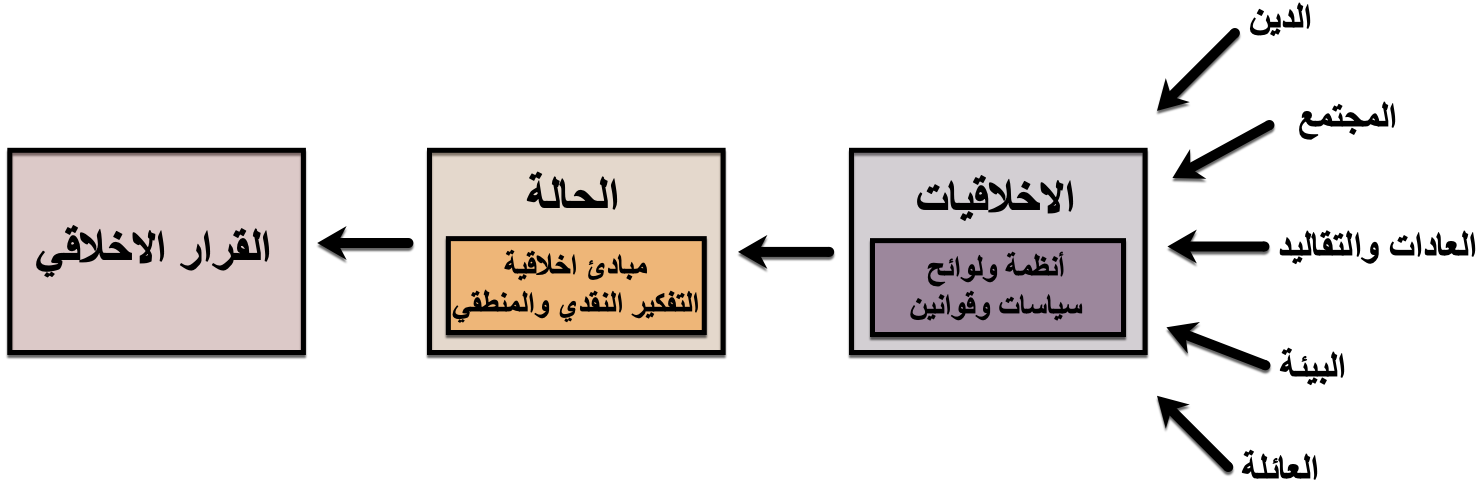

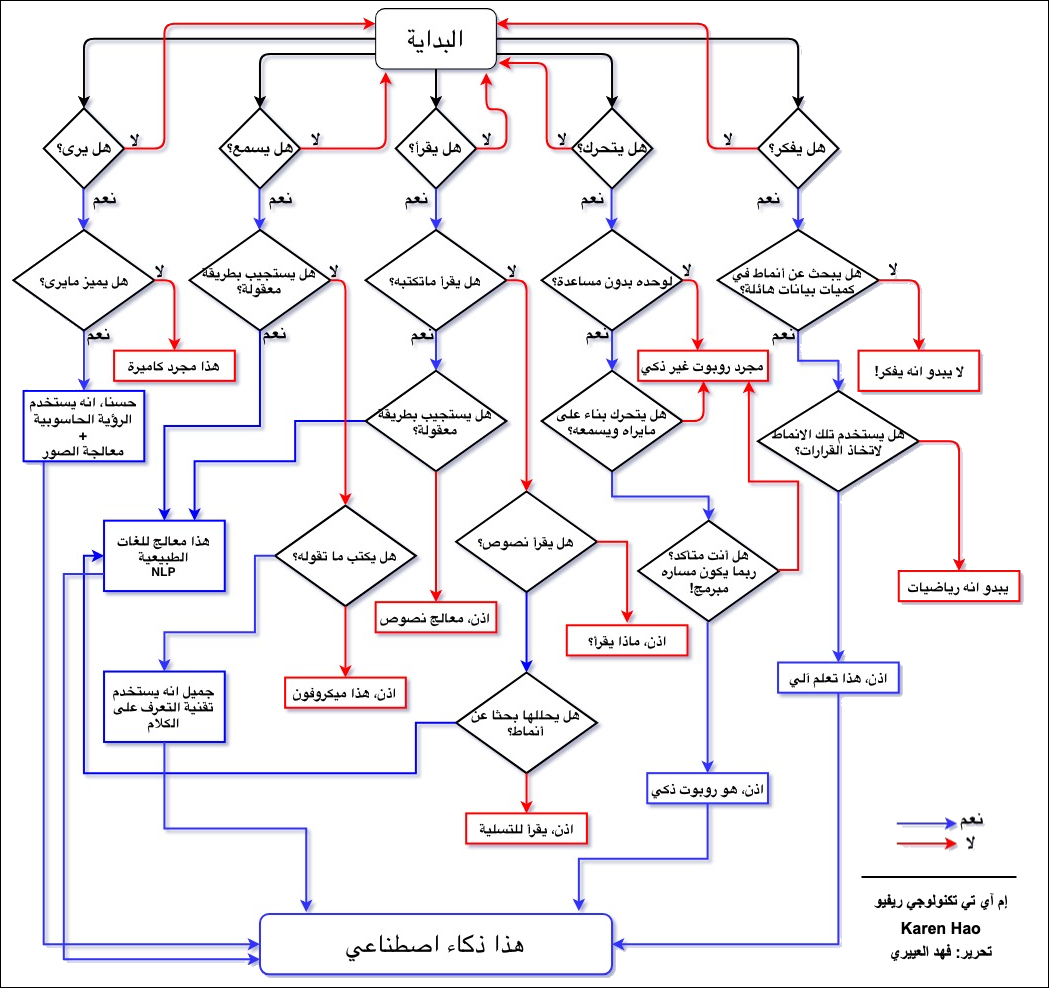

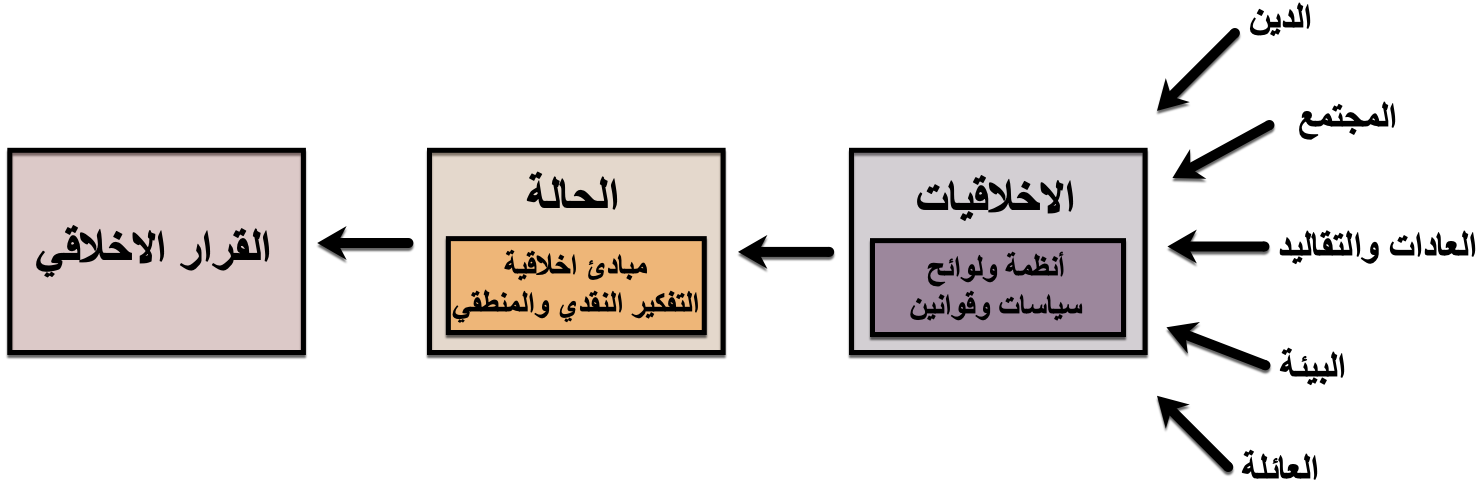

وقبل أن أتطرق لإطار حوكمة الذكاء الاصطناعي، فلابد أن أفصّل قليلا في اخلاقيات الذكاء الاصطناعي حيث أنها أحد الركائز المهمة في الحوكمة. الاخلاقيات بشكل مجرد هي المبادئ والقيم التي تقود شخص او مجتمع للتصرف بشكل صحيح. من أين تأتي هذه الاخلاقيات؟ كما يظهر بالشكل أدناه، فهي تُستقى من عدة مصادر مثل الدين، المجتمع، العادات والتقاليد، البيئة، والعائلة. بعض تلك الاخلاقيات تكون مكتوبة ومنصوص عليها على شكل قوانين او سياسات او لوائح مثل التعاليم الدينية والقوانين المدنية وبعضها مكتسب من المخالطة والبيئة والانتماء مثل العادات والتقاليد. هذه الاخلاقيات عبارة عن خطوط عريضة، فحينما يتعرض الفرد لحالة معينة فإنه يستدعيها ويمحصها بالتفكير النقدي والمنطقي ويحاكم الحالة طبقا لمبادئه الأخلاقية (وجهة نظر، نوايا، تفضيلات، رغبات، ومعتقدات) ليتخذ القرار الأخلاقي المناسب، مثلا التبرع بالأعضاء. فالبشر يعتمدون على الاخلاقيات بشكل أساسي لإجراء ثلاثة أمور رئيسية وهي التفاعل مع الاخرين، اتخاذ القرارات، وتنفيذ المهام.

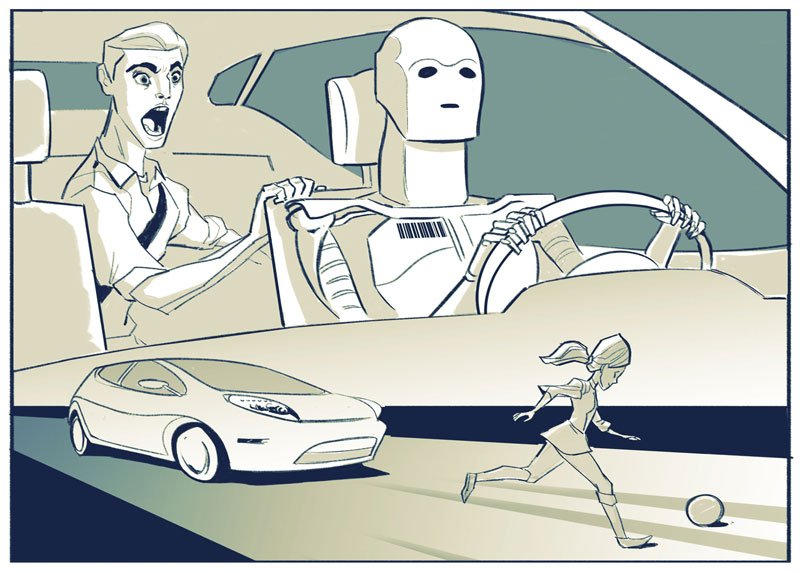

من هذا المنطلق وكون تقنيات الذكاء الاصطناعي أصبحت جزء لا يتجزأ من حياتنا بحيث نعتمد عليها في تعاملاتنا وقراراتنا ومهامنا فلابد لها من اخلاقيات تحكم طريقة عملها وتحكم طريقة استخدامنا لها خصوصا ان بعض تقنيات الذكاء الاصطناعي أصبحت ذاتية التحكم. تلك القرارات يجب ان تُبنى على اخلاقيات كما بنيت قرارات الانسان. واخلاقيات الذكاء الاصطناعي لابد ان تكون مستمدة من اخلاقيات المجتمع التي هي فيه لكي يثق فيها المجتمع ويعتمد عليها وتكون إيجابية نافعة.

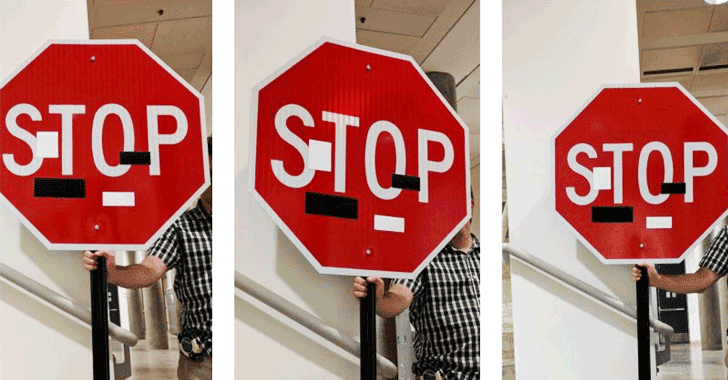

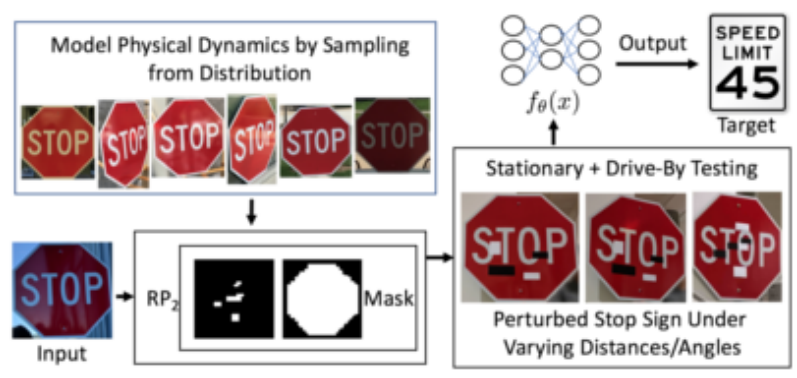

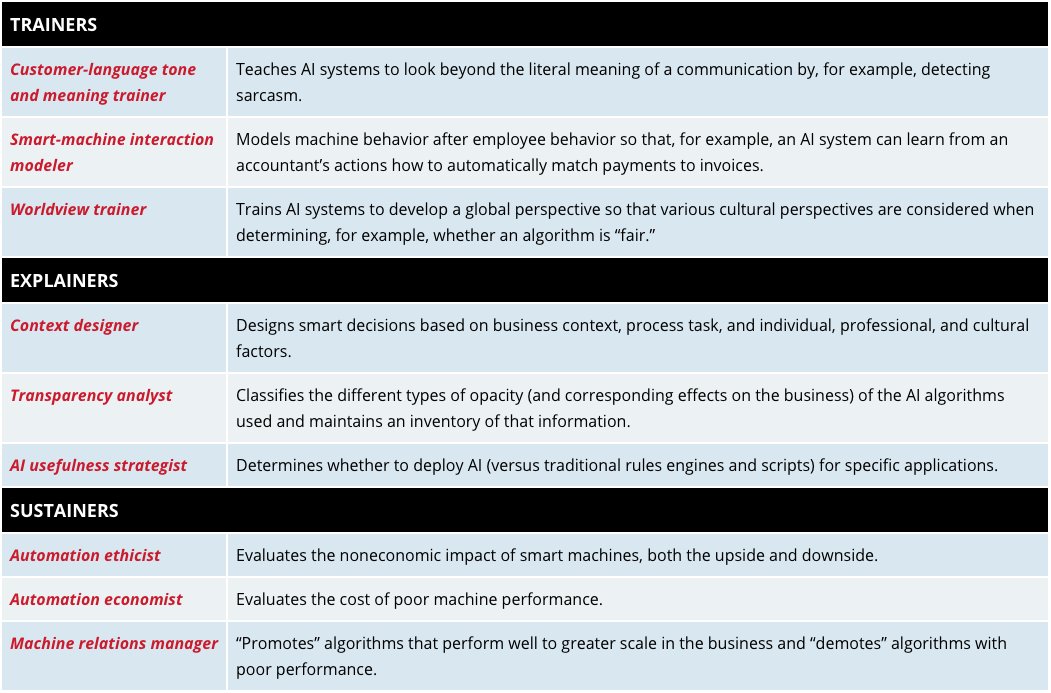

نستطيع ان نعرف اخلاقيات الذكاء الاصطناعي على انها مجموعة من القيم الأخلاقية التي تحكم أنشطة الذكاء الاصطناعي. ويمكن تقسيم أخلاقيات الذكاء الاصطناعي لثلاث فئات، اخلاقيات العاملين في صناعة الذكاء الاصطناعي (المصنّعون، المبرمجون، والمصممون)، الاخلاقيات الموجودة داخل أنظمة الذكاء الاصطناعي، واخلاقيات الأشخاص الذين يتعاملون مع الذكاء الاصطناعي (المستخدمون، والمجتمع). إذن، بشكل عام على العاملين بمجال صناعة تقنيات الذكاء الاصطناعي ان ينتجوا تقنيات نافعة مفيدة، وأن يتم دمج الاخلاقيات في الآلات والأنظمة الذكية بحيث أنها لا تضر حينما تتواصل مع أحد أو تؤدي مهمة أو تتخذ قرار، اضافة إلى أهمية حسن تعامل المستخدم والمجتمع مع التقنيات الذكية بحيث لا يتم تعليمها مايضر الآخرين ولا استخدامها بشكل خاطئ.

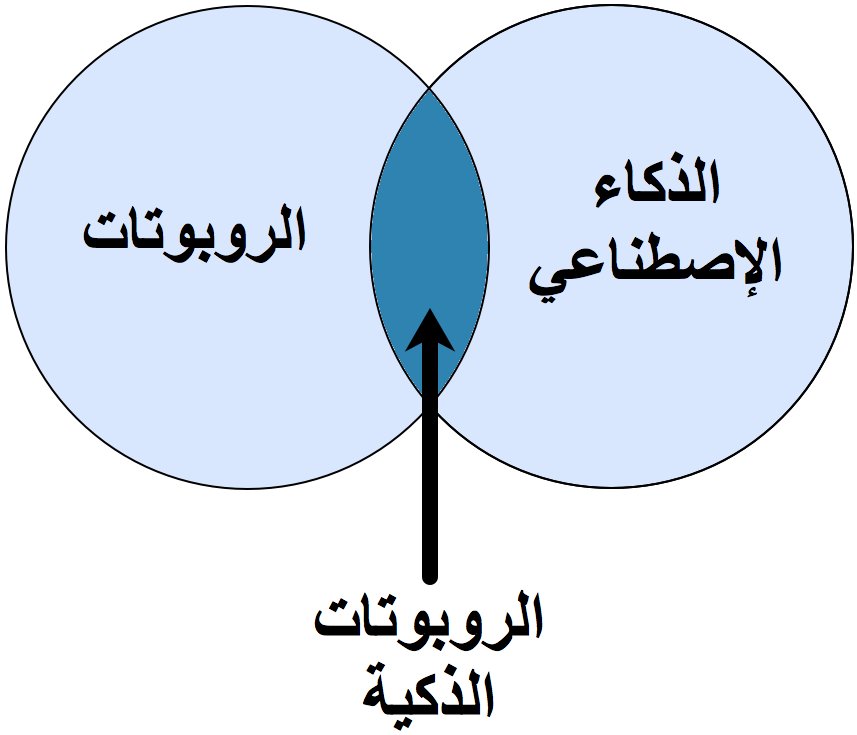

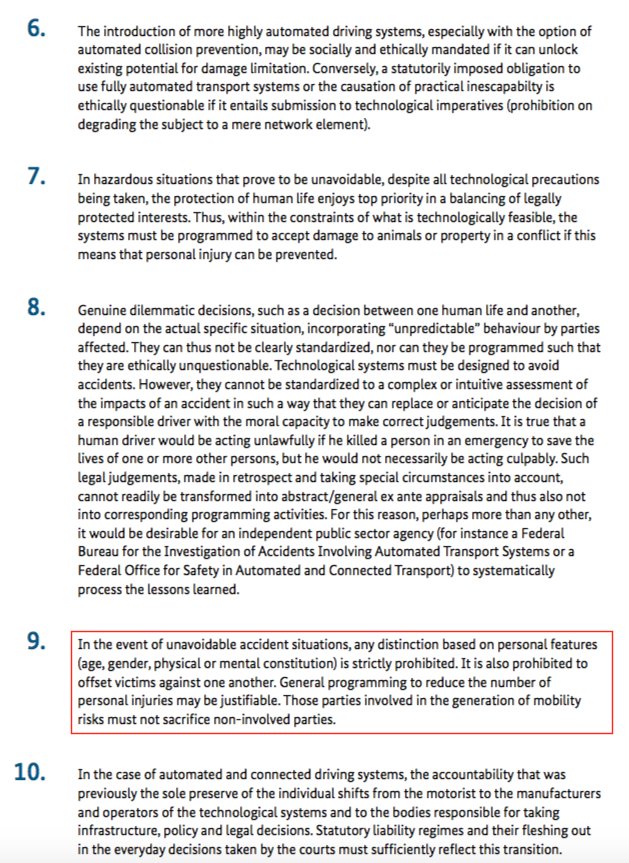

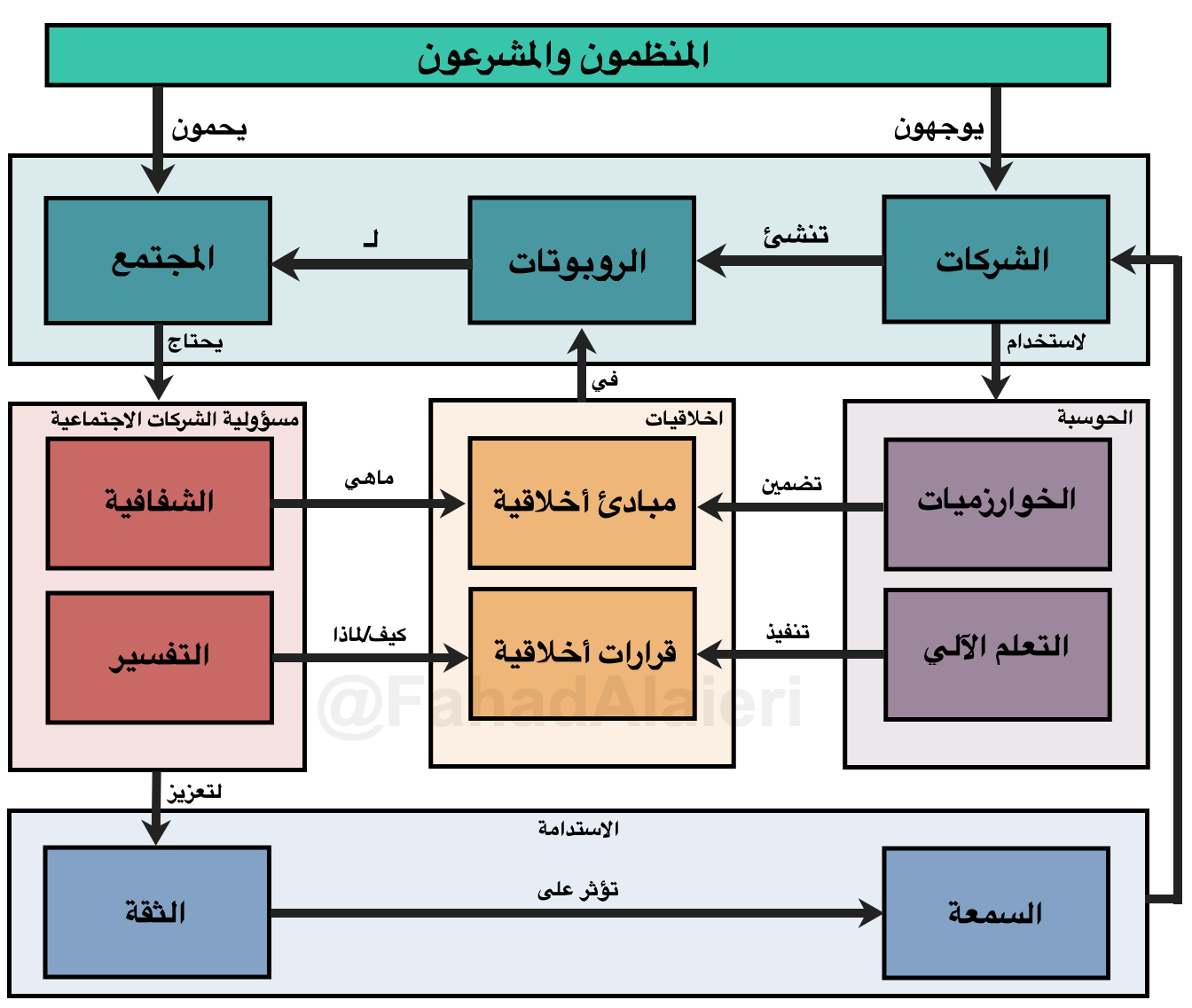

في الشكل أدناه، أستعرض إطار عام لحكومة الذكاء الاصطناعي يشمل أصحاب المصالح بمختلف المستويات (علما أني طورت هذا الإطار في وقت سابق وكنت قد أسمتيه اطار الثقة). الشكل يركز على اخلاقيات الروبوت لكن ما ينطبق على الروبوت ينطبق على البوت أيضا وهما نوعي الذكاء الاصطناعي.

في هذا الإطار هناك ثلاث جهات رئيسية وهي الحكومة، الشركات التقنية، والمجتمع. علاقتها مع بعضها كالتالي: الحكومة وتشمل المشرّعين وصنّاع السياسات تقوم بتوجيه الشركات التقنية من أجل حماية المجتمع. توجيه الشركات يكون باستخدام تقنيات الحوسبة بحيث تستخدم الشركات الخوارزميات لدمج المبادئ الأخلاقية داخل الروبوتات، وتستخدم التعلم الآلي لتعليم الروبوتات على القرارات الأخلاقية. من جانب آخر المجتمع يحتاج الى مسؤولية الشركات الاجتماعية والتي تتطلب منها شيئين وهما الشفافية والتفسير. يجب ان تكون الشركات شفافة من ناحية اعلان ماهي المبادئ الأخلاقية التي زرعتها بالروبوتات، وتكون واضحة في تفسير قرارات الروبوتات الأخلاقية في حال حدوث خطأ ما. المسؤولية الاجتماعية للشركات تعزز ثقة المجتمع في التقنيات الذكية وهذا يؤدي إلى الحفاظ على سمعة الشركات مما ينمي الاستدامة والتي بدورها تعود بالنفع على الشركات. هذا الإطار يعطي نظرة واسعة عن علاقة الحكومة، الشركات التقنية، والمجتمع في تحقيق السلم التقني ان صح التعبير.